Chat With RTX 是一个 Demo,用来将您自己的资料(文档、笔记、视频或其他数据)与大语言模型建立连接,从而令 LLM 更具个性化。利用检索增强生成 (RAG)、TensorRT-LLM 和 RTX 加速,您可以与自定义聊天机器人对话,快速灵活地获得聊天机器人根据您的内容给出的见解。此外,由于 Chat with RTX 完全在 Windows RTX PC 或工作站本地以安全的方式运行,因此您可以更快获得更满意的结果。

与您的笔记,文档和视频进行 AI 对话

Chat With RTX 支持多种文件格式,包括文本文件、pdf、doc/docx 和 xml。您只需在该应用中指定包含目标文件的文件夹,该应用便会在几秒内将目标文件加载到库中。不仅如此,您还可以提供 YouTube 播放列表的 URL,然后该应用会自动加载播放列表中的视频的转写内容,让您能够查询视频中包含的内容。

AI 智聊,专为开发者而设计

Chat With RTX 技术演示版基于 GitHub 中的 TensorRT-LLM RAG 开发者参考项目构建而成。开发者可以借鉴该参考项目,自行开发和部署面向 RTX、基于 RAG 且由 TensorRT-LLM 加速的应用。

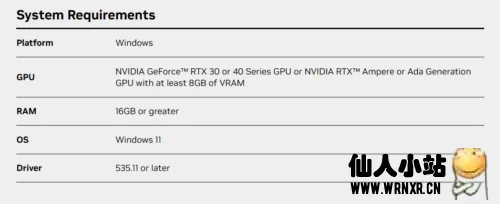

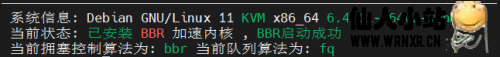

目前环境需求:

![图片[1]-英伟达Nvidia发布基于RTX显卡的本地AI:Chat With RTX-仙人小站](https://www.wrnxr.cn/wp-content/uploads/2024/02/image-1-1024x417.png)

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

- 最新

- 最热

只看作者